Flux详细介绍、安装教程、整合包

更新: 12/21/2024 字数: 0 字 时长: 0 分钟

概述

版本区别

- 查看版本区别

在线体验地址🚧

建议

- 需要魔法上网

8步加速出图-最快5秒🚀

说明

- 基于4090测试,最快5秒+,仅供参考

- 加速模型,主要应用场景为:快速出图,验证

提示词质量、lora以及功能等,避免长时间等待 - 以下是3种加速出图方案,主要针对

低显存和高配用户的建议,以下只作参考 - 注意:不能用加速后出的图和原版模型做

强对比,没有意义,速度快是以牺牲一定质量为前提,当然,实测下来,质量都是符合预期的。

方案1:Flux.1-Turbo-Alpha

说明

- 该加速方式为使用

lora进行加速

由

阿里妈妈创意团队开发的基于FLUX.1-dev模型的8步蒸馏版lora。使用特殊设计的判别器来提高蒸馏质量。该模型可以用于

文生图、重绘控制和其他FLUX相关模型。建议guidance_scale=3.5和lora_scale=1。我们的更低步数的版本将在后续发布。

方案2:Hyper8-GGUF

说明

- 该加速方式为使用

unet进行加速

Flux.D 和字节跳动的 8 步 HyperSD LoRA 技术结合,生成了一个叫做 GGUF 的新模型。这个模型非常省内存,而且速度很快。

只需要 8 步就能生成一张高质量的图片,而且对电脑的显存要求不高,最低只需要 6.2 GB(使用 Q4_0 量化)。

相对于 FastFlux 和其他

Dev-Schnell合并的优势:

- 质量更好:相比其他类似模型(比如

FastFlux),它在 8 步内就能生成更清晰、更有表现力的图片。- 灵活调节:因为是 DEV 模型,所以可以自由调整提示的

敏感度和创造力,适合不同需求。- 兼容性好:和

Dev LoRA完全兼容,比其他模型更灵活。不过,需要至少

8 步才能达到最佳效果,但这也是为了保证质量。根据你的显卡显存大小,可以选择不同版本:

Q4_0和Q4_1适合 8 GB 显存;Q5_0和Q5_1适合 11 GB 显存;Q8_0适合显存更大的显卡。

注意:使用 CPU 卸载,即使 VRAM 不适合,您也可以运行模型。

方案3:Hyper-SD

说明

- 该加速方式为使用

lora进行加速

最近,出现了一系列扩散感知蒸馏算法,以减轻与

扩散模型 (DM)的多步推理过程相关的计算开销。当前的

蒸馏技术通常分为两个不同的方面:i) ODE 轨迹守恒; ii) ODE 轨迹重新表述。但是,这些方法会受到严重性能下降或域偏移的影响。

为了解决这些限制,我们提出了

Hyper-SD,这是一种新颖的框架,它协同融合了

ODE 轨迹保持和重新制定的优势,同时在阶跃压缩期间保持近乎无损的性能。

警告

- Hyper-SD的

lora权重,需要设置为0.125左右 - 不同配置的采样器,速度不一样,最快的实测为

euler+simpler,质量更好的为:hexun+beta

- arXiv:https://arxiv.org/abs/2404.13686

- 官方地址:Hyper-SD

- Lora下载地址:字节跳动/Hyper-SD

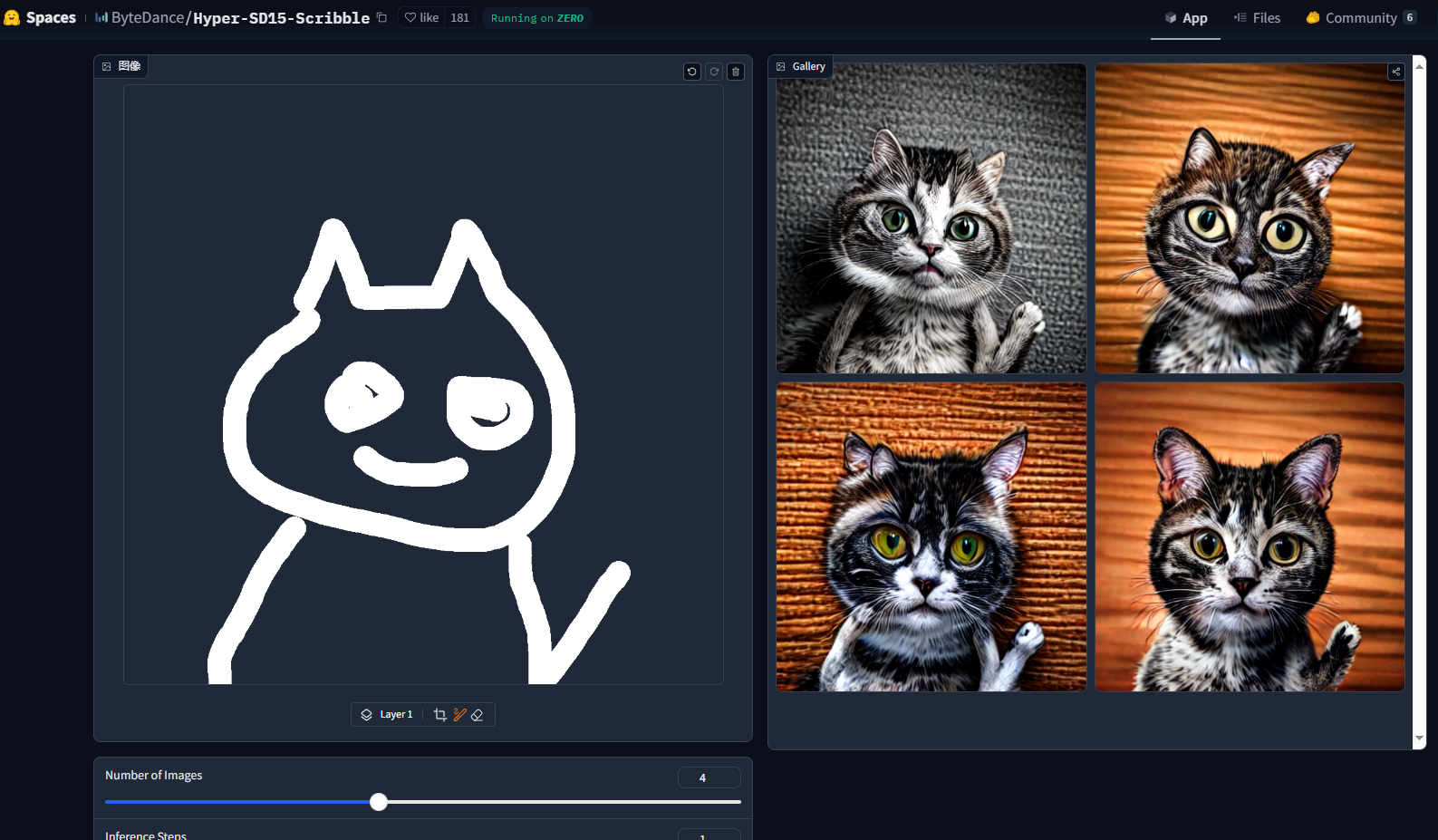

SDXL1步文生图体验:Hyper SDXL 1Step T2ISD1.5草绘生图体验:Hyper SD15 Scribble

三种方案实测对比

说明

- 以下数据,基于

4090相同提示词、其他参数以官方建议为准,8步实测 - 不加其他任何

lora等 - Flux

原版和flux1-dev-Q8_0.gguf版使用加速存在差异,建议不要混用

| 方案 | 类型 | 耗时 (首次/后续) | 优点 | 缺点 | 16G及以上用户建议 | 8-12G低显存用户建议 |

|---|---|---|---|---|---|---|

| Flux-turbo-alpha | Lora | 20s / 10s | 使用 Lora,支持原版 Flux-dev 模型,出图质量中上 | GGUF 量化模型加速效果一般(32s/18s) | 出图质量相对于Hyper8稍好 | 如果显存足够,可以考虑,但 GGUF 加速效果一般 |

| Hyper8-Lora | Lora | 17s / 5-6s | 使用 Lora,支持原版 Flux-dev 模型,出图质量中等 | GGUF 量化模型加速效果一般 (25s/17s) | 推荐,后续出图速度最快 | 如果显存足够,优先考虑此方案,速度优势明显 |

| Hyper8-GGUF | Unet | 25s / 13-15s | 使用 GGUF 量化模型,对低显存友好,出图质量中等 | 出图质量略逊于 Flux-turbo-alpha,后续出图速度慢于 Hyper8-Lora | 不推荐,除非特别在意低显存 | 推荐,尤其是在显存不足的情况下 |

使用总结:

- 低显存:

Hyper8-GGUF是最佳选择,牺牲一些速度和质量来换取更低的显存占用。 - 追求速度:

Hyper8-Lora在后续出图速度上有明显优势。 - 追求质量:

Flux-turbo-alpha在质量上略胜一筹。 - 16G及以上 (显存充足): 推荐

Hyper8-Lora,平衡了速度和质量,或者选择Flux-turbo-alpha追求更高质量。

补充说明:

表格中的时间为

平均值,实际耗时可能受硬件配置和版本其他因素影响。如果非常在意速度,并且显存充足,可以尝试使用

Hyper8-Lora配合GGUF 量化模型进行测试,看是否能在可接受的质量下获得更快的速度。与 Flux.1 Dev 相关的所有许可条款均适用。

Flux-tools工具🔧

1. Flux Fill

局部重绘

图片扩充

原版模型

fp8_e4m3fn版模型

说明:FLux1 Dev Fill转换为

fp8_e4m3fn以减少内存消耗(x0.5)

GGUF版模型

对于国内用户,请将:huggingface.co 域名替换成 hf-mirror.com 即可免魔法下载。

2. FLUX Redux

原图参考

多图融合

原版模型

sigclip_vision

- 说明:依赖

sigclip_vision_patch14_384.safetensors模型 - 下载地址:地址

3. FLUX Depth

景深参考

GGUF版

对于国内用户,请将:huggingface.co 域名替换成 hf-mirror.com 即可免魔法下载。

4. FLUX Canny

边缘参考

GGUF版模型

- FLUX.1-Canny GGUF 地址: https://huggingface.co/SporkySporkness/FLUX.1-Canny-dev-GGUF

对于国内用户,请将:huggingface.co 域名替换成 hf-mirror.com 即可免魔法下载。

常用功能 🍕

手部修复 🖐🏼

参考:地址